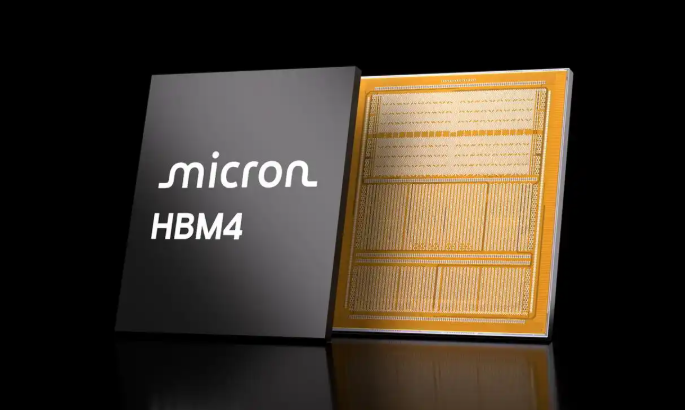

当全球AI算力竞赛进入白热化阶段,谁掌握了下一代内存技术,谁就扼住了高性能计算的咽喉。美光科技近日宣布向多个关键客户交付HBM4 12Hi 36GB内存样品,这款基于1β工艺的革新性产品,不仅实现了2.0TB/s的惊人带宽,更在性能与能效上双双突破,为即将到来的AI计算革命埋下伏笔。

技术突破:性能提升60%背后的三大创新

美光此次出样的HBM4内存采用12层堆叠封装技术,每个堆栈配备24Gb DRAM Die,通过优化的1β工艺实现了三大关键突破。其带宽超过2.0TB/s,较前代HBM3E提升60%以上;能效改进达20%,显著降低AI服务器的功耗成本;更搭载先进的MBIST内存自检功能,确保大规模部署时的稳定性。

值得注意的是,美光特别强调这项技术优化了逻辑xPU与内存间的数据交互效率。这意味着在AI推理任务中,加速器能够更快响应数据请求,尤其适合大语言模型实时推理等高带宽需求场景。这种内存与逻辑芯片的协同设计理念,正引领着"内存中心计算"的新趋势。

产业竞速:美光与SK海力士的HBM4对决

在HBM4赛道,美光并非孤军奋战。SK海力士早在3月就率先出样12层HBM4,同样采用24Gb芯片和MR-MUF键合工艺,技术参数与美光产品高度接近。两家巨头都瞄准了2026年这个关键时间节点,计划与下一代AI平台同步实现量产。

但美光的布局更具前瞻性,除HBM4外还披露了更先进的HBM4E研发计划。这项技术将采用台积电逻辑代工工艺,支持定制化逻辑基础芯片,实现内存与逻辑半导体的深度集成。这种"单封装"解决方案将彻底改变传统内存架构,预计可带来更高的性能密度和能效比。

应用前景:从英伟达Rubin到AMD Instinct的算力革命

根据行业预测,HBM4将率先应用于英伟达Rubin AI架构和AMD Instinct MI400系列加速器。美光透露其HBM4产品线可能堆叠多达16个DRAM芯片,单芯片容量32GB,采用2048位宽接口,这些特性使其特别适合训练千亿参数级大模型。

目前HBM市场需求持续火爆,美光已接到2025年的产能预订。随着AI服务器向更高带宽、更低延迟演进,HBM4及其后续技术将成为决定算力上限的关键因素。在这场内存技术竞赛中,美光能否凭借1β工艺优势和台积电联盟后来居上,2026年的量产表现将给出最终答案。

从样品交付到量产冲刺,HBM4的发展轨迹清晰可见。当2026年AI计算进入新纪元时,这些今天看似超前的内存技术,或将成为支撑智能世界的标准配置。美光此次技术亮剑,不仅是一次产品迭代,更是对未来计算架构的重新定义。

240

240

浙公网安备 33010502006866号

浙公网安备 33010502006866号