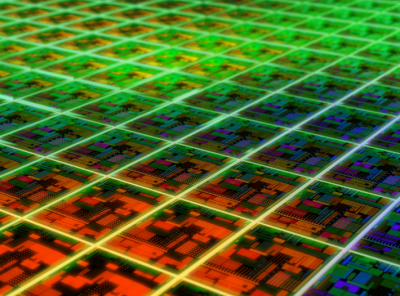

你是否想过,当ChatGPT在全球引发AI狂潮时,支撑这些大型语言模型运行的底层硬件到底是什么?在NVIDIA GPU几乎垄断市场的今天,谷歌却悄悄打出了一张王牌——其自研的张量处理单元TPU正展现出恐怖的性能优势。

2016年,谷歌首次公开TPU架构时就震惊了整个行业。这款定制芯片专为深度学习设计,在推理任务上可实现比GPU高出10倍的性价比。秘密在于其创新的脉动阵列设计,通过优化矩阵乘法这一神经网络的核心运算,TPUv1实现了惊人的能效比。当时谷歌内部测算,使用TPU运行AlphaGo与李世石对决的算法,能耗仅为GPU方案的1/5。

TPU的成功并非偶然。回溯历史,神经网络经历过多次"寒冬",而硬件限制正是重要原因之一。GPU的出现打破了这一僵局,但谷歌发现,当AI模型规模扩大到服务十亿级用户时,通用GPU的效率瓶颈日益凸显。这正是TPU诞生的契机——一款为谷歌旗下搜索、YouTube、Gmail等超大规模服务量身定制的AI加速器。

经过多代迭代,TPUv3已具备令人咋舌的计算能力。单个Pod配置1024块TPUv3芯片,可提供超过100PetaFLOPS的混合精度计算性能。这意味着它能在几小时内完成需要传统GPU集群数天才能跑完的大模型训练任务。更关键的是,谷歌云使这些超级计算资源变得触手可及,开发者无需自建数据中心就能调用TPU算力。

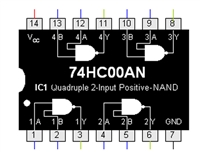

TPU的独特之处还体现在其软硬件协同设计理念。从指令集到编译器堆栈,每个环节都为张量运算优化。以矩阵乘法为例,传统CPU需要数百条指令完成的操作,TPU只需一条指令即可执行。这种深度定制使得TPU在执行Transformer等现代神经网络架构时,吞吐量能达到同类GPU的3-5倍。

尽管谷歌在生成式AI竞赛中看似落后,但其TPU技术储备不容小觑。随着AI模型参数突破万亿级别,计算效率将成为决胜关键。当大多数企业还在为GPU短缺发愁时,谷歌已通过TPU构建了完整的AI基础设施闭环。这或许解释了为何行业专家普遍认为,谷歌完全有能力在AI军备竞赛中后来居上。

从AlphaGo到PaLM2,TPU支撑了谷歌几乎所有重大AI突破。这款被誉为"深度学习领域最成功的定制芯片"不仅改写了硬件规则,更重塑了AI研发的范式。当下一次AI浪潮来袭时,谷歌的TPU很可能会成为决定胜负的隐形王牌。

浙公网安备 33010502006866号

浙公网安备 33010502006866号