全球AI军备竞赛已悄然烧向HBM产业链最底层。最新供应链消息显示,英伟达正在秘密研发3nm工艺的HBM Base Die(基础芯片),这项代号"Nova Core"的自主研发计划直指当前被韩系厂商垄断的HBM技术命门。

破局之战:英伟达剑指HBM全栈自主

在H100加速卡中,HBM成本占比超60%已成英伟达最大的"阿喀琉斯之踵"。当前全球HBM市场被三星、SK海力士垄断92.9%份额,美光仅占7.1%。这种结构性风险在AI芯片产能争夺战中愈发凸显——单张H100 NVL显卡需要堆叠12颗HBM芯片,总成本高达2880美元。

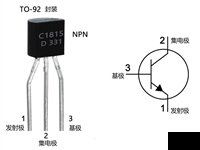

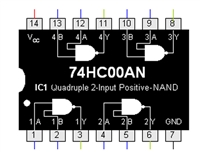

基板芯片作为HBM3E的核心载体,承担着内存堆叠互连与信号处理的关键职能。传统方案中,美光采用1β(第五代10nm)工艺的硅通孔技术,三星则依托第六代10nm DRAM制程,两家在8/12层堆叠技术上已建立极高壁垒。英伟达选择从最底层的3nm基板芯片切入,既能规避直接对抗DRAM制造的技术鸿沟,又能通过先进制程实现弯道超车。

3nm工艺带来的降维打击

据产业链人士透露,英伟达的3nm基板芯片将采用台积电N3E工艺制造,晶体管密度较当前主流方案提升40%。这种跨代际的技术跃迁带来三重优势:首先,1.5μm级别的硅通孔节距可将互连密度提升至现有方案的2.3倍;其次,集成自研的NVLink 5.0控制器,单芯片支持1.8TB/s的超高带宽;最重要的是能将功耗控制在竞品方案的70%以内。

这绝非简单的工艺升级。AMD在MI350加速器上已证明异构堆叠的可行性——其采用3nm XCD计算单元搭配N6 IOD芯片的方案,在1.2平方厘米内塞入1850亿晶体管。英伟达若能实现3nm基板芯片+4nm HBM3E的异构集成,单卡显存带宽有望突破12TB/s,较当前H200的4.8TB/s提升150%。

2027年量产背后的产业博弈

选择2027年下半年试产的时间节点暗藏深意。届时美光12层HBM3E将完成与AWS的联合验证,三星则可能推出基于第七代10nm DRAM的HBM4。英伟达需要在这三年窗口期内解决两大挑战:其一是3nm DRAM工艺的良率爬坡,目前行业平均良率仅65%-75%;其二是构建自主的TSV硅通孔技术体系,这项被三星垄断的技术直接决定着堆叠层数与散热效能。

这场豪赌背后是价值50亿美元的HBM市场争夺战。Gartner预测2025年HBM市场规模将达49.76亿美元,年增速高达148%。英伟达若掌握基板芯片自主权,不仅能摆脱对韩系厂商的依赖,更能通过定制化设计进一步拉大AI算力优势。正如当年苹果自研M系列芯片重塑PC格局,半导体巨头们正在HBM战场开启新的权力游戏。

2343

2343

浙公网安备 33010502006866号

浙公网安备 33010502006866号