近日,全球三大存储芯片厂商SK海力士、三星电子和美光科技在12层HBM3E(High Bandwidth Memory 3rd Generation Enhanced)的研发和量产方面均取得了显著进展。这一进展标志着存储芯片技术又迈上了一个新的台阶,将对人工智能、高性能计算和数据中心等领域产生深远影响。

9月26日,SK海力士宣布公司已开始量产全球首款12层堆叠的HBM3E芯片,实现了现有HBM产品中最大的36GB容量。该产品堆叠了12颗3GB DRAM芯片,厚度与现有的8层产品相同,但容量提升了50%。运行速度提高至9.6Gbps,这意味着在搭载四个HBM的单个GPU运行大型语言模型(LLM)如“Llama 3 70B”时,每秒可读取35次700亿个整体参数。SK海力士计划在年内向客户提供这款12层HBM3E芯片,以满足人工智能企业日益增长的需求,并继续保持其在人工智能存储器市场的领先地位。

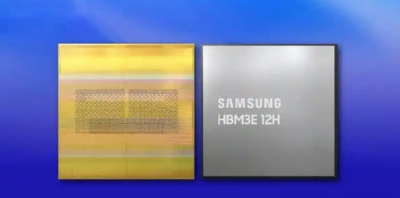

与此同时,三星电子也在积极推进12层HBM3E的研发和量产。今年2月,三星电子首次推出了HBM3E 12H,支持全天候最高带宽达1280GB/s,产品容量同样达到了36GB。与8层堆叠的HBM3 8H相比,HBM3E 12H在带宽和容量上大幅提升超过50%。三星电子表示,这一新产品正是为了满足行业对更高容量HBM的迫切需求而设计的。据三星公司高管透露,他们已准备好量产12层HBM3E芯片,并计划在今年下半年根据多家客户的需求扩大供应。

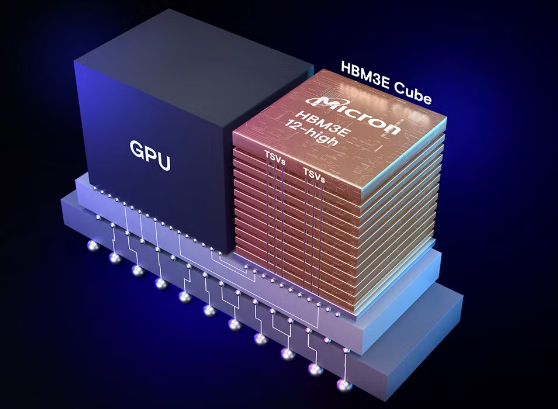

美光科技也不甘落后,于今年9月宣布推出12层堆叠的HBM3E。美光表示,随着AI工作负载的不断发展和扩充,记忆体频宽和容量对提升系统效能越来越关键。为了满足这些需求,美光正在向主要产业合作伙伴提供可量产的HBM3E 12层堆叠记忆体,并在整个AI生态系统进行认证。美光的12层堆叠36GB HBM3E不仅功耗大幅降低,而且封装中的DRAM容量增加了50%,可以让拥有700亿个参数的大型AI模型(如Llama 2)运行于单个处理器上。美光还提到,其HBM3E 12层堆叠记忆体整合了完全可编程MBIST,能够以全规格速度运行系统典型流量,为加快验证提供了更大的测试覆盖范围,缩短了产品上市时间,并提高了系统可靠性。

这三大厂商的12层HBM3E进展不仅体现在技术研发和量产方面,还体现在市场份额的争夺上。据CFM闪存市场数据显示,预计至2024年底,三星、SK海力士和美光合计将达到30万片的HBM月产能,其中三星HBM增产最为激进。预计明年全球HBM市场规模将上望300亿美元,HBM将占DRAM晶圆产能约15%至20%。英伟达作为HBM市场的最大买家,在Blackwell Ultra、B200A等产品推出后,其在HBM市场的采购比重将突破70%。

随着人工智能应用的指数级增长,HBM3E 12层堆叠产品有望成为未来系统的优选解决方案,满足系统对更大存储的需求。凭借超高性能和超大容量,HBM3E 12层堆叠产品将帮助客户更加灵活地管理资源,同时降低数据中心的总体拥有成本(TCO)。

浙公网安备 33010502006866号

浙公网安备 33010502006866号