当机器人开始用人类的思维方式理解世界,具身智能会迎来怎样的飞跃?智元机器人最新开源的GO-1模型给出了令人惊艳的答案。这项由"天才少年"稚晖君团队打造的突破性技术,不仅开创性地提出了ViLLA架构,更将通用具身基座模型的开发门槛降到了历史新低。

具身智能的三大痛点与ViLLA的破局之道

长期以来,具身智能领域面临三重困境:依赖少量真机数据导致泛化能力薄弱;基于VLM的模型难以构建通用动作理解;视频生成技术则受限于语义理解缺失。GO-1模型提出的ViLLA架构犹如一场及时雨,通过分层设计巧妙化解了这些难题。

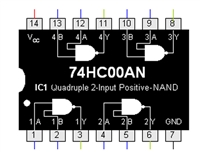

其核心创新在于将传统的VLA架构升级为Vision-Language-Latent-Action三层结构。第一层VLM多模态理解基于InternVL-2B构建,赋予机器人处理视觉、力觉和语言信息的"感官系统";中间的LatentPlanner犹如"大脑中枢",通过隐式动作标记实现高级任务规划;末端的ActionExpert则像"运动神经元",用扩散模型生成精确动作序列。这种设计使得GO-1仅需5%的真机数据就能实现传统方法100%的效果。

GenieStudio平台:让具身开发像搭积木一样简单

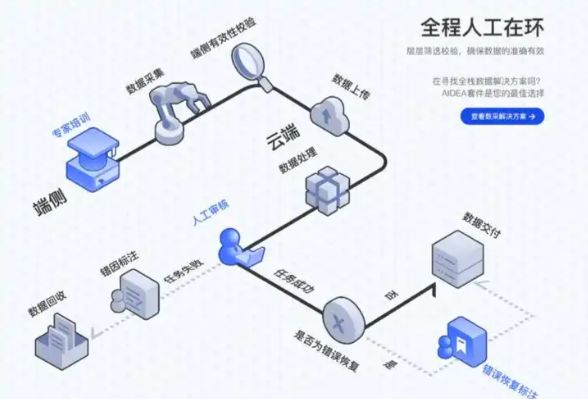

智元机器人同步推出的GenieStudio开发平台,可能是最具实用价值的"开源伴侣"。这个一站式工具链整合了从数据采集到真机部署的全流程,开发者无需再在不同工具间疲于奔命。平台内置的VideoTraining方案特别值得关注,它能将人类操作视频转化为高质量训练数据,解决了具身智能的数据瓶颈问题。

更令人惊喜的是GO-1模型展现出的跨平台兼容性。测试数据显示,该模型在松灵机器人、方舟机器人等不同本体上均保持稳定性能,在GenieSim仿真环境中的任务完成率较传统方法提升47%。这种"一次训练,多端适配"的特性,极大降低了企业采用新技术的迁移成本。

开源生态下的具身智能革命

将如此前沿的技术完全开源,智元机器人显然在下一盘大棋。通过GitHub和Huggingface发布的模型文件,配合详细的开发文档,即使是初学者也能快速上手。这种开放姿态正在催生一个蓬勃发展的开发者社区,已有团队利用GO-1在工业质检、康复护理等场景实现创新应用。

具身智能的"Linux时刻"或许已经来临。当技术门槛被GO-1这样的开源模型不断降低,我们有望看到机器人应用呈现指数级增长。从实验室走向千家万户,具身智能的普及之路正在ViLLA架构的照耀下加速延伸。这场由中国人引领的技术革命,或将重新定义人机交互的未来图景。

732

732

浙公网安备 33010502006866号

浙公网安备 33010502006866号